Con todo el excelente material que tenemos en estos días, parece que deberíamos disfrutar de una excelente visualización sin importar qué, pero ¿y si no lo hacemos? La publicación de preguntas y respuestas de SuperUser de hoy busca aclarar las cosas para un lector confundido.

SuperUser, una subdivisión de Stack Exchange, una agrupación comunitaria de sitios web de preguntas y respuestas, nos ofrece la sesión de preguntas y respuestas de hoy.

Foto cortesía de lge (Flickr).

La cuestión

El lector SuperUser Alkamid quiere saber por qué hay una diferencia notable en la calidad entre HDMI-DVI y VGA:

Tengo un monitor Dell U2312HM conectado a una computadora portátil Dell Latitude E7440. Cuando los conecto a través de una computadora portátil -> cable HDMI -> adaptador HDMI-DVI -> monitor (el monitor no tiene una toma HDMI) la imagen es mucho más nítida que si la conecto a través de una computadora portátil -> adaptador miniDisplayPort-VGA -> cable VGA -> monitor.

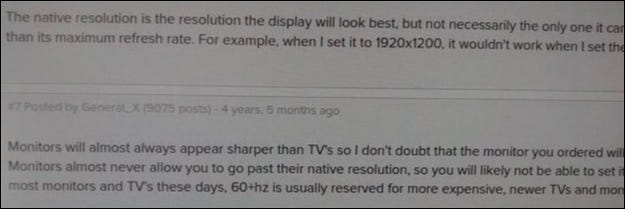

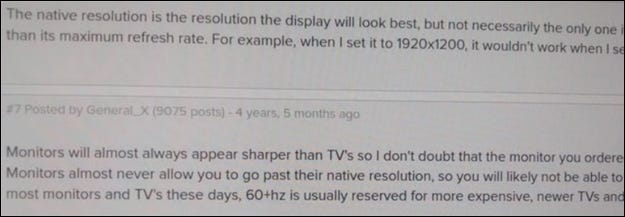

La diferencia es difícil de capturar con una cámara, pero mira mi intento a continuación. He intentado jugar con los ajustes de brillo, contraste y nitidez, pero parece que no puedo obtener la misma calidad de imagen. La resolución es 1920 * 1080 con Ubuntu 14.04 como sistema operativo.

VGA:

HDMI:

¿Por qué la calidad es diferente? ¿Es intrínseco a estos estándares? ¿Podría tener un cable VGA o un adaptador mDP-VGA defectuoso?

¿Por qué hay una diferencia de calidad entre los dos?

La respuesta

Los colaboradores de SuperUser Mate Juhasz, youngwt y Jarrod Christman tienen la respuesta para nosotros. En primer lugar, Mate Juhasz:

VGA es la única señal analógica entre las mencionadas anteriormente, por lo que esta ya es una explicación de la diferencia. El uso del adaptador puede deteriorar aún más la calidad.

Algunas lecturas adicionales: HDMI frente a DisplayPort frente a DVI frente a VGA

Seguido de la respuesta de youngwt:

Suponiendo que el brillo, el contraste y la nitidez sean los mismos en ambos casos, podría haber otras dos razones por las que el texto es más nítido con HDMI-DVI.

El primero ya se ha dicho, VGA es analógico, por lo que tendrá que pasar por la conversión de analógico a digital dentro del monitor. Teóricamente, esto degradará la calidad de la imagen.

En segundo lugar, suponiendo que esté utilizando Windows, existe una técnica llamada ClearType (desarrollada por Microsoft) que mejora la apariencia del texto manipulando los subpíxeles de un monitor LCD. VGA se desarrolló teniendo en cuenta los monitores CRT y la noción de subpíxel no es la misma. Debido al requisito de que ClearType use una pantalla LCD y el estándar VGA no le dice al anfitrión las especificaciones de la pantalla, ClearType se deshabilitaría con una conexión VGA.

Recuerdo haber oído hablar de ClearType a uno de sus creadores en un podcast de This (). Developers (). Life () IIRC, pero este Artículo de Wikipedia también apoya mi teoría. Además, HDMI es compatible con DVI y DVI admite Identificación de pantalla electrónica (EDID).

Con nuestra respuesta final de Jarrod Christman:

Los otros tienen buenos puntos, pero la razón principal es un reloj obvio y un cambio de fase. VGA es analógico y está sujeto a interferencias y desajustes de los lados de envío y recepción analógicos. Normalmente, usaríamos una plantilla como esta:

Luego, ajuste el reloj y la fase del monitor para obtener la mejor coincidencia y la imagen más nítida. Sin embargo, dado que se trata de una señal analógica, estos ajustes pueden cambiar con el tiempo, por lo que lo ideal es utilizar una señal digital.

¿Tiene algo que agregar a la explicación? Habla en los comentarios. ¿Quiere leer más respuestas de otros usuarios expertos en tecnología de Stack Exchange? Consulte el hilo de discusión completo aquí..